高并发场景,三类业务的架构挑衅不一样:

- QQ类业务,用户首要读写本身的数据,访问根本带有uid属性,数据访问锁辩论较小

- 微博类业务,用户的feed主页由别人发布的消息构成,数据读写有肯定锁辩论

- 12306类业务,并发量很高,险些全部的读写锁辩论都会合在少量数据上,难度最大

那么对于秒杀类业务,体系上和业务上分别能怎样优化呢,这是本文要讨论的题目。

体系层面,秒杀业务的优化方向怎样?

首要有两项:

(1)将哀求只管拦截在体系上游,而不要让锁辩论落到数据库。

传统秒杀体系之以是挂,是由于哀求都压到了后端数据层,数据读写锁辩论严峻,并发高相应慢,险些全部哀求都超时,访问流量大,下单乐成的有用流量小。

一趟火车2000张票,200w个人同时来买,没有人能买乐成,哀求有服从为0。

画外音:此时体系的服从,还不如线下售票窗口。

(2)充实使用缓存。

秒杀买票,这是一个典范的读多写少的业务场景:

- 车次查询,读,量大

- 余票查询,读,量大

- 下单和付出,写,量小

一趟火车2000张票,200w个人同时来买,最多2000个人下单乐成,其他人都是查询库存,写比例只有0.1%,读比例占99.9%,非常得当利用缓存来优化。

秒杀业务,常见的体系分层架构怎样?

秒杀业务,可以利用典范的效劳化分层架构:

- 端(欣赏器/APP),最上层,面向用户

- 站点层,访问后端数据,拼装html/json返回

- 效劳层,屏蔽底层数据细节,提供数据访问

- 数据层,DB存储库存,固然也有缓存

这四层分别应当怎样优化呢?

1、一败涂地端上的哀求拦截(欣赏器/APP)

想必春节各人都玩过微信的摇一摇抢红包,用户每摇一次,真的就会今后端发送一次哀求么?

回忆抢票的场景,用户点击“查询”按钮以后,体系卡顿,用户发急,会不自发的再去频仍点击“查询”,不光没用,反而平白无端增添体系负载,均匀一个用户点5次,80%的哀求是这么多出来的。

JS层面,可以限定用户在x秒以内只能提交一次哀求,从而低落体系负载。

画外音:频仍提交,可以友爱提示“频率过快”。

APP层面,可以做雷同的事变,固然用户疯狂的在摇微信抢红包,但实在x秒才向后端发起一次哀求。

画外音:这就是所谓的“将哀求只管拦截在体系上游”,欣赏器/APP层就能拦截80%+的哀求。

不外,端上的拦截只能挡住平凡用户(99%的用户是平凡用户),步伐员firebug一抓包,写个for循环直接调用后端http接口,js拦截根本不起作用,这下怎么办?

二、站点层的哀求拦截

怎样抗住步伐员写for循环调用http接口,起首要确定用户的唯一标识,对于频仍访问的用户予以拦截。

用什么来做用户的唯一标识?

ip?cookie-id?别想得太复杂,购票类业务都必要登录,用uid就能标识用户。

在站点层,对同一个uid的哀求举行计数和限速,比方:一个uid,5秒只准透过1个哀求,如许又能拦住99%的for循环哀求。

一个uid,5s只透过一个哀求,别的的哀求怎么办?

缓存,页面缓存,5秒内到达站点层的其他哀求,均返回前次返回的页面。

画外音:车次查询和余票查询都可以或许这么做,既能包管用户体验(最少没有返回404页面),又能包管体系的强健性(使用页面缓存,把哀求拦截在站点层了)。

OK,通过计数、限速、页面缓存拦住了99%的平凡步伐员,但仍有些高端步伐员,比方黑客,控制了10w个肉鸡,手里有10w个uid,同时发哀求,这下怎么办?

三、效劳层的哀求拦截

并发的哀求已到了效劳层,怎样进拦截?

效劳层非常清晰业务的库存,非常清晰数据库的抗压本领,可以根据这两者举行削峰限速。

比方,业务效劳很清晰的知道,一列火车只有2000张车票,此时透传10w个哀求去数据库,是没成心义的。

画外音:假设数据库每秒只能抗500个写哀求,就只透传500个。

用什么削峰?

哀求队列。

对于写哀求,做哀求队列,每次只透传有限的写哀求去数据层(下订单,付出如许的写业务)。

只有2000张火车票,纵然10w个哀求过来,也只透传2000个去访问数据库:

- 假如前一批哀求均乐成,再放下一批

- 假如前一批哀求库存已不敷,则后续哀求全部返回“已售罄”

对于读哀求,怎么优化?

cache抗,不管是memcached照旧redis,单机抗个每秒10w应当都是没什么题目的。

画外音:缓存做程度扩展,很轻易线性扩容。

云云削峰限流,只有非常少的写哀求,和非常少的读缓存mis的哀求会透到数据层去,又有99%的哀求被拦住了。

四、数据库层

颠末前三层的优化:

- 欣赏器拦截了80%哀求

- 站点层拦截了99%哀求,并做了页面缓存

- 效劳层根据业务库存,和数据库抗压本领,做了写哀求队列与数据缓存

你会发现,每次透到数据库层的哀求都是可控的。

db根本就没什么压力了,闲庭信步。

画外音:这类业务数据量不大,无需分库,数据库做一个高可用就行。

此时,透2000个到数据库,全部乐成,哀求有服从100%。

画外音:优化前,10w个哀求0个乐成,有用性0%。

按照上面的优化方案,实在压力最大的反而是站点层,假设真实有用的哀求数是每秒100w,这部门的压力怎么处置惩罚?

办理方向有两个:

(1)站点层程度扩展,通过加呆板扩容,一台抗5000,200台搞定;

(2)效劳降级,扬弃哀求,比方扬弃50%;

原则是要掩护体系,不能让全部用户都失败。

站点层限速,是个每个uid的哀求计数放到redis里么?吞吐量很大环境下,高并发访问redis,网络带宽会不会成为瓶颈?

同一个uid计数与限速,假如担忧访问redis带宽成为瓶颈,可以这么优化:

(1)计数直接放在内存,如许就省去了网络哀求;

(2)在nginx层做7层平衡,让一个uid的哀求落到同一个呆板上;

画外音:这个计数对数据同等性、正确性要求不高,纵然效劳重启计数丢了,大不了重新开始计。

除了体系上的优化,产物与业务还可以或许做一些折衷,低落架构难度。

业务折衷一

一样平常来说,下单和付出放在同一个流程里,可以或许进步转化率。对于秒杀场景,产物上,下单流程和付出流程异步,放在两个环节里,可以或许低落数据库写压力。以12306为例,下单乐成后,体系占住库存,45分钟以内付出即可。

业务折衷二

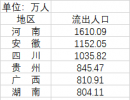

一样平常来说,全部用户规则雷同,体验会更好。对于秒杀场景,产物上,差别地区分时售票,固然不是全部用户规则雷同,但可以或许极大低落体系压力。北京9:00开始售票,上海9:30开始售票,广州XX开始售票,可以或许分担体系压力。

业务折衷三

秒杀场景,由于短时间内并发较大,体系返回较慢,用户心情非常焦虑,大概会频仍点击按钮,对体系造成压力。产物上可以优化为,一旦点击,不管体系是否返回,按钮立即置灰,不给用户时机频仍点击。

业务折衷四

一样平常来说,表现详细的库存数目,可以或许增强用户体验。对于秒杀场景,产物上,只表现有/无车票,而不是表现详细票数量,可以或许低落缓存镌汰率。

画外音:表现库存会镌汰N次,表现有没有只会镌汰1次。更多的,用户关注是否有票,而不是票有几张。

无论怎样,产物技能运营一起,目的是同等的,把事变做好,不存在谁是甲方,谁是乙方的关系。

总结

对于秒杀体系,除了产物和业务上的折衷,架构计划上首要有两大优化方向:

(1)只管将哀求拦截在体系上游;

(2)读多写少用缓存;

300x180 AD

300x180 AD

说点什么...